11가지의 세부 신뢰성 요구사항에 대한 평가 및 검증 거친 후 인증 획득해 포티투마루가 대한민국 최초로 생성형 AI 기반 초거대 언어 모델(LLM)에 대한 AI 신뢰성 인증을 획득했다고 6일 밝혔다. 과학기술정보통신부(이하 과기정통부)와 한국정보통신기술협회(TTA)는 인공지능(AI) 시스템의 신뢰성을 확보하기 위해 'AI 신뢰성 인증(CAT, Certification of AI Trustworthiness)' 제도를 운영하고 있다. CAT 인증은 국내 기업의 인공지능 신뢰성 제고와 경쟁력 강화를 위해, AI 모델 또는 시스템을 대상으로 AI 거버넌스 체계 구축과 투명성, 책무성 등의 신뢰속성을 갖췄는지를 심사하는 인증이다. TTA는 ISO/IEC AI 신뢰성 관련 국제 표준, UNESCO, NIST, EU AI 법안 등 국제 사회가 정의한 AI 신뢰성 요구 조건에 따라 위험 기반 평가를 수행하고, 기업이 신뢰할 수 있는 AI 제품을 개발하도록 지원하고 있다. 이 외에도 과기정통부와 협력해 AI 신뢰성·품질 대상 운영, 레드팀 챌린지 행사 등 다양한 AI 신뢰성 관련 활동을 지속적으로 전개하고 있다. 포티투마루도 올해 4월에 국내 생성형 AI를 대상으로 열린

인공지능팩토리(대표 김태영)는 업스테이지와 고도화된 온프레미스 환경의 거대 언어 모델(LLM) 구축을 위한 업무협약을 체결했다고 23일 밝혔다. 이번 협약식은 온라인으로 진행됐으며, 인공지능팩토리의 김태영 대표이사와 업스테이지의 이영규 본부장을 비롯한 양사의 테크 리더들이 참여했다. 이번 협약을 통해 양사는 기업을 대상으로 하는 생성형 챗봇 공급 목적으로 오프라인 환경에서 작동하는 시스템 개발에 집중할 계획이다. 또한 지식 기반 챗봇 서비스와 리포트 생성 서비스의 신뢰성을 높이기 위해 RAG(실시간 생성) 성능을 향상시킬 수 있는 기술 협약도 예정되어 있다. 첫 활동으로 인공지능팩토리는 업스테이지가 개발한 사전학습 거대 언어 모델 ‘Solar LLM’을 새로 추가하여 문서 구조를 자동으로 이해하고 손쉽게 추출할 수 있도록 설계된 강력한 API인 Upstage Layout Analysis 기능을 탑재할 예정이다. 인공지능팩토리 김태영 대표는 “현재 자사가 보유한 온프레미스 LLM 운영 플랫폼에 업스테이지의 모델을 추가함으로써 고객에게 최적화된 온프레미스 환경을 제공할 예정”이라고 말했다. 한편, 인공지능팩토리는 최근 리눅스데이타시스템과의 업무협약을 체결하며 기

초거대 AI 클라우드 및 거대 언어 모델(LLM) 갖춘 차세대 온보드 엣지 AI 로봇 플랫폼 개발에 협력키로 로보틱스 플랫폼 업체 인티그리트와 AI 반도체 업체 퓨리오사AI가 ‘온보드 엣지 AI 로보틱스 플랫폼’ 공동 개발 관련 업무협약(MOU)을 체결했다. 온보드 엣지 AI 로보틱스 플랫폼은 이동형 로봇 및 고성능 모빌리티 구현을 위한 기술로, 하드웨어·소프트웨어 등에 AI 전용 칩셋과 구동 환경이 통합된 제어보드를 제공하는 기술이다. 인티그리트 5G 기반 로봇 플랫폼과 퓨리오사AI 비전 AI 및 언어모델 전용 프레임워크를 HW/SW 환경에 통합한다. 인티그리트에 따르면 해당 플랫폼을 통해 현장에서 도출된 데이터를 실시간으로 가공·분석·추론하는 등으로 AI 지원 AMR 시스템, 스마트 모빌리티 구현이 가능하다. 또 각종 오픈소스 환경에서 모듈식 구성요소를 활용하고, 맞춤형 하드웨어 및 AI 시스템을 구축해 서버, 엣지 장치에 적용하거나 배포할 수 있다. 양사는 1세대 신경망 처리장치(Neural Prosessing Unit 이하 NPU)를 로보틱스 플랫폼에 통합한 온보드 엣지 AI 로봇 플랫폼 ‘에어패스 F1’을 발표한 데 이어, 퓨리오사 AI 2세대 NP

아마존웹서비스(이하 AWS)는 엔씨소프트가 고객이 머신러닝(ML)을 시작할 수 있도록 사전 학습된 오픈소스 모델을 제공하는 아마존 세이지메이커 점프스타트를 기반으로 거대 언어 모델(LLM)을 출시했다고 29일 밝혔다. 엔씨소프트는 아마존 세이지메이커 점프스타트에 바르코(VARCO: Via AI, Realize your Creativity and Originality) LLM 제품군을 출시함으로써 다양한 산업 분야에서 새로운 콘텐츠를 만들 수 있는 인공지능(AI)의 일종인 생성형 AI의 도입을 가속화하고, 국내 기업들이 모국어를 활용해 특화된 애플리케이션을 쉽게 구축할 수 있도록 지원한다는 목표다. LLM은 텍스트 처리 및 요약에서 질문 응답에 이르기까지 광범위한 생성형 AI 애플리케이션을 구동할 수 있는 언어에 초점을 맞춘 ML 모델의 하위 집합이다. 이러한 LLM은 산업을 혁신할 수 있는 잠재력을 가지고 있지만, LLM 구축, 학습, 배포 과정은 몇 주에서 몇 달이 소요되고 수백억 원의 비용이 들기 때문에 많은 기업이 접근하지 못하고 있다. 아마존 세이지메이커 점프스타트는 고객이 엔씨소프트의 바르코 LLM과 같은 사전 구축된 솔루션을 활용해 생성형 AI를

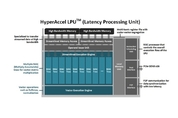

챗GPT 기술이 가져올 변화에 대해 전 세계가 주목하고 있는 가운데, KAIS가 2.4배 가격 효율적인 챗GPT 핵심 AI 반도체를 개발했다. KAIST 전기및전자공학부 김주영 교수 연구팀은 챗GPT에 핵심으로 사용되는 거대 언어 모델의 추론 연산을 효율적으로 가속하는 AI 반도체를 개발했다고 4일 밝혔다. 김교수 연구팀이 개발한 AI 반도체 ‘LPU(Latency Processing Unit)’는 거대 언어 모델의 추론 연산을 효율적으로 가속한다. 메모리 대역폭 사용을 극대화하고 추론에 필요한 모든 연산을 고속으로 수행 가능한 연산 엔진을 갖춘 AI 반도체이며, 자체 네트워킹을 내장하여 다수 개 가속기로 확장이 용이하다. 이 LPU 기반의 가속 어플라이언스 서버는 업계 최고의 고성능 GPU인 엔비디아 A100 기반 슈퍼컴퓨터보다 성능은 최대 50%, 가격 대비 성능은 2.4배가량 높였다. 이는 최근 급격하게 생성형 AI 서비스 수요가 증가하고 있는 데이터센터의 고성능 GPU를 대체할 수 있을 것으로 기대한다. 이번 연구는 김주영 교수의 창업기업인 하이퍼엑셀에서 수행했으며 미국시간 7월 12일 샌프란시스코에서 진행된 국제 반도체 설계 자동화 학회(DAC)에서